A mediados de la década de 1990, y a pesar de las múltiples promesas que lo habían acompañado desde su nacimiento, el campo de la Inteligencia Artificial no pasaba por sus mejores momentos. Aunque se habían producido numerosos avances teóricos y la capacidad de computación había aumentado enormemente, las aplicaciones prácticas estaban tardando demasiado en llegar, e incluso las prometedoras redes neuronales habían caído en desuso fuera de la investigación académica.

En 1959, David H. Hubel y Torsten Wiesen habían descubierto dos tipos distintos de neuronas en la corteza visual del cerebro, células simples y células complejas, las cuales formaban una relación jerárquica. Los especialistas en el incipiente campo de la inteligencia artificial se inspiraron en el modelo neuronal desarrollado por Hubel y Torsten y desarrollaron las primeras redes neuronales artificiales, las cuales apenas pasaban en sus inicios de ser un mero concepto teórico. El primer desafío al que se enfrentarían los investigadores era el de cómo “entrenar la red neuronal”, es decir, la definición de los algoritmos que guiarían su proceso de aprendizaje. Durante las décadas siguientes, se sucedieron numerosos avances teóricos y la estructura de las redes neuronales artificiales fue haciéndose más compleja.

En 1997, la máquina de IBM Deep Blue ganaba por primera vez un enfrentamiento completo con un campeón del mundo humano de ajedrez. La expectación generada por el evento resucitó de nuevo el interés del público en los avances en inteligencia artificial, pero la máquina no representaba un avance revolucionario real, más allá de su fuerza bruta y de su ingente librería de partidas almacenadas. La máquina era incapaz de aprender y solo sabía hacer una cosa: jugar al ajedrez. Pero el cambio de milenio iba a traer un repentino cambio de perspectiva para la inteligencia artificial: los continuos aumentos en la velocidad de los procesadores, junto con la nueva disponibilidad de datos que trajo la explosión de Internet, aceleraron el desarrollo de las aplicaciones prácticas, y el campo científico que había sido una promesa eterna pasó a transformarse en una realidad.

¿Y por qué es tan importante la disponibilidad de datos?

Porque la fiabilidad de los algoritmos de inteligencia artificial depende directamente del volumen de datos con los que estos pueden ser entrenados. El proceso de aprendizaje de una red neuronal es muy similar al de cualquier ser humano, ya que la red comienza el proceso con una ignorancia absoluta respecto a lo que ha de evaluar pero aprende de sus errores tras cada decisión. Por ejemplo, una red neuronal encargada de identificar los diez dígitos existentes solo sabe que el investigador va a presentarle millones de casos, a los cuales habrá de asignar una etiqueta de cero a nueve. Sus primeras predicciones serán aleatorias y erróneas, pero después de clasificar mal un cero repetidas veces acabará comprendiendo que los ceros suelen tener, entre otras características, el centro de la imagen libre de trazo. De la misma forma, acabará aprendiendo a distinguir un 3 de un 8 a partir de los trazos a la izquierda que los diferencian (“trazos en la zona izquierda = 8”, “sin trazos en la zona izquierda = 3”).

En última instancia, gran parte del avance se ha debido también a un cambio de paradigma en la forma en que los algoritmos son entrenados. Hasta hace unos años, se confiaba en el crecimiento exponencial de la velocidad de los procesadores para resolver los problemas de aprendizaje. Pero el mundo informático ha ido virando paulatinamente hacia la solución de problemas poniendo a trabajar muchos ordenadores estándares en paralelo, en contraposición a la práctica anterior de confiarlo todo a superordenadores con un coste desorbitado. Así, hoy tiene más importancia el desarrollo de algoritmos que sean capaces de correr en paralelo en un gran número de ordenadores personales que en procesos dependientes de una única fuerza bruta.

La inteligencia artificial está invadiendo nuestro día a día con numerosas aplicaciones prácticas. Repasemos algunas de las más relevantes.

Reconocimiento y transcripción del lenguaje

Una de las aplicaciones más útiles de la inteligencia artificial es el reconocimiento automático de la voz. Aunque existen aplicaciones prácticas desde hace algunos años en el campo médico o militar, la utilidad real del reconocimiento de voz ha explotado durante estos últimos años con los asistentes de los teléfonos móviles, especialmente en el caso de Google. El dictado fiable de mensajes o la búsqueda por voz de lugares son ya posibles desde la popularización del sistema operativo Android, tras la mejora de unos sistemas difícilmente usables hace solo una década.

Identificación de spam o del “estado de ánimo” de un mensaje de texto

Los algoritmos de aprendizaje están aprendiendo también a procesar ingentes cantidades de mensajes humanos con el fin de discernir si un correo es o no spam o si una noticia es buena o mala. El área conocida como “análisis de sentimientos” identifica las palabras con connotaciones más extremas para así clasificar mensajes humanos entre distintos estados de humor. En el desarrollo de esta área ha sido fundamental la nueva disponibilidad de datos obtenidos a partir de redes sociales como Facebook o Twitter. Por ejemplo, los estudios cinematográficos son capaces ahora de ajustar mejor el número de salas de exhibición de sus películas en función de la expectación, positiva o negativa, de los posibles espectadores antes del estreno.

Identificación de imágenes

La identificación de imagen tiene multitud de aplicaciones prácticas. Puede servir por ejemplo para etiquetar automáticamente personas en las fotografías o para luchar contra el uso fraudulento de imágenes en sitios web de Internet. Además, es el ingrediente clave de los coches automáticos que Google lleva perfeccionando desde hace varios años, los cuales pueden suponer en el medio plazo una revolución para el transporte urbano, ofreciendo una mayor precisión de conducción y aumentando así la capacidad de las vías, facilitando de paso la posibilidad de compartir los vehículos en mayor medida.

Recomendaciones personalizadas

Una clase especial de algoritmos de inteligencia artificial son los algoritmos de recomendación, ampliamente utilizados por tiendas online de libros, música o cine. Netflix, la principal empresa de exhibición online de películas y series en Estados Unidos –la cual tiene pendiente aún su llegada a España-, es quizás el caso más representativo de este tipo de soluciones. Netflix aplica decenas de algoritmos distintos para evaluar tus gustos en función de las evaluaciones de películas que han realizado individuos parecidos al usuario, recomendando aquellas con mayor probabilidad de agradar. Tras cada película visionada, Netflix pide de nuevo la opinión al usuario, para así contrastarla con la recomendación realizada y poder ajustar las futuras predicciones.

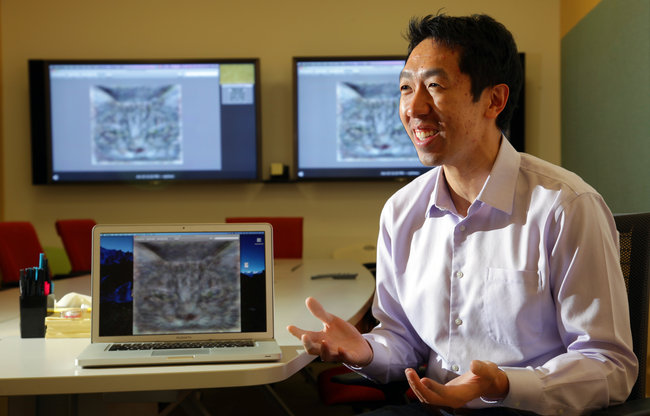

Aprendizaje de conceptos y clases de objetos

Aunque este tipo de algoritmos no tienen aún una aplicación directa, uno de los experimentos más populares de los últimos años una red neuronal -construida por Google con la ayuda del investigador Andrew Ng, de la Universidad de Stanford- capaz de reconocer el concepto de “gato” a partir de miles de videos no etiquetados obtenidos de YouTube. Es decir, se mostraron a la red neuronal los videos sin aclararle qué había en cada uno de ellos. Tras el proceso de aprendizaje, la red era capaz de identificar aquellos videos que tenían un curioso elemento en común: un gato. Sin ser específicamente instruida en el concepto de gato, la red consiguió identificar una clase de objeto, animal en este caso, común a muchos vídeos, lo cual supone un avance en la capacidad de abstracción de un ordenador.

La inteligencia artificial está aquí para quedarse, y cada día surgen nuevas aplicaciones prácticas con impacto directo en nuestras vidas. En su cara más oscura se encuentra la posibilidad de que muchos servicios de espionaje se dediquen a rastrear toda la información disponible en la red, y que incluso empresas o individuos con objetivos dudosos puedan también llegar a hacerlo. Los gobiernos habrán de realizar un mayor esfuerzo para garantizar la privacidad y limitar los posibles comportamientos poco éticos que esta nueva tecnología nos trae. Tanto para mal como para bien, las posibilidades serán cada vez más ilimitadas.

2 Comentarios

Abel,

Un articulo relacionado:

http://www.theatlantic.com/magazine/archive/2013/11/the-man-who-would-teach-machines-to-think/309529/

Basicamente, lo que esta haciendo google hoy en dia es un tipo de fuerza bruta. Con muchos usos, sin duda, pero es un metodo diferente al del cerebro humano y hay dudas que pueda avanzar mas de cierto umbral.

Muy buen resumen de algunas líneas más aplicadas de la IA. Ejemplos interesantes explicados de forma cercana.