Sabemos mucho más de lo que podemos explicar. Esta es la famosa “paradoja” de Polanyi, economista austríaco que se dio cuenta de la existencia de conocimiento que los humanos no podemos explicitar. Somos capaces de hacer infinidad de cosas, pero no hay manera de explicar con claridad cómo las hacemos. ¿Podríamos definir una serie de reglas codificadas para identificar a un familiar -por ejemplo, nuestro padre- entre un grupo de individuos similares? O, por ejemplo, ¿qué mecanismos precisos nos llevan a reconocer un objeto simple, como una silla?

Aunque parezca increíble, no somos capaces de describir analíticamente los mecanismos por los cuales reconocemos a una persona determinada entre un conjunto de personas similares, o a un objeto simple entre otros. Esto es una atribución puramente humana. Un computador no puede hacerlo.

¿Podría un ordenador identificar una silla? Si le diéramos instrucciones precisas de qué es una silla (mediante conocimiento codificado: “instrumento de cuatro patas, tabla plana y respaldo”), inevitablemente se equivocaría en múltiples casos. Hay sillas sin respaldos, sillas de tres patas, e infinidad de objetos que parecen sillas, pero no lo son. Si aceptamos que las sillas pueden no tener respaldo, ¿cómo puede diferenciar un ordenador una silla de una mesa? La única manera: haber visto muchas sillas.

Y, ¿cómo escribir código en un computador para que éste reconozca a nuestro padre? Es imposible…

La habilidad de reconocer objetos se basa en un tipo de conocimiento no codificable, no explicitado, y basado en la experiencia. Es el conocimiento tácito. Cuando reconocemos la especie de un grupo de pájaros en vuelo por la forma de moverse, cuando realizamos los movimientos precisos para romper un huevo en el canto de una taza para hacer una tortilla, o cuando identificamos la cara de un conocido, después de años sin verlo, pese a sus cambios evidentes, estamos utilizando esa clase extraña de conocimiento, el conocimiento tácito. Lo tenemos, pero no sabemos cómo expresarlo. Ni mucho menos, cómo codificarlo en instrucciones precisas. Un conocimiento que, bajo los métodos clásicos de programación, no ha podido transmitirse a un sistema informático, y que ha sido una gran reserva de trabajo cognitivo humano.

Hasta ahora, sólo se han automatizado las tareas que se basan en conocimiento explícito, no tácito.

Pero hoy, una tecnología disruptiva está cambiando el paradigma de funcionamiento de las máquinas. Es la inteligencia artificial, o, concretamente el machine learning (subcampo de la primera). Hasta hace poco, un programa informático sólo era la expresión ordenada de conocimiento codificable. Sus programadores identificaban una secuencia de rutinas, las escribían, literalmente, en un software, y el procesador ejecutaba exactamente aquello que estaba codificado en las líneas de programación.

El ordenador reproducía lo que sabían (y habían escrito en líneas de código) sus programadores. Eso sí, con una potencia de cálculo y velocidad de ejecución infinitamente superiores a las humanas. Pero muchas tareas habituales, tanto cotidianas como complejas, no podían ser informatizadas porque no conocíamos sus instrucciones explícitas.

Hoy, la estrategia de desarrollo de programas informáticos ha cambiado de forma revolucionaria bajo el prisma de la inteligencia artificial. Las máquinas no son programadas de forma “lineal”, como antiguamente, sino que son capaces de aprender de la experiencia, desde cero, y reprogramarse a sí mismas para ser cada vez más eficientes en la consecución de un logro. Con tecnología basada en redes neuronales artificiales, que simulan el cerebro humano.

AlphaGo, el algoritmo de inteligencia artificial que ha derrotado ya por dos veces a los sucesivos campeones mundiales de Go (en 2016 y 2017) aprendió por sí mismo, desde la nada. Se le marcaron las restricciones (reglas de juego: qué movimientos podía realizar y cuáles no), el objetivo (condiciones en que se gana la partida), y se le entrenó observando miles de partidas reales, y jugando otras tantas contra sí mismo. Hasta que desarrolló autónomamente, mediante prueba y error, un nivel de conocimiento tácito que lo hizo invencible.

Las máquinas ya desarrollan conocimiento tácito propio en base a la experiencia. A partir de este momento, lo que puede suceder es apasionante. Las aplicaciones en negocios, en medicina, en derecho, o en educación, son inimaginables. Quizá su coche, o la puerta de su casa, le reconocerán mediante visión artificial y le abrirán la puerta en cuanto se aproxime. Pronto, cámaras de visión artificial detectarán la propensión a la compra, o el estado anímico del cliente en punto de venta. En poco tiempo, un algoritmo digital con llegada a su móvil podrá diagnosticarle si esa mancha inquietante en su mano es o no un cáncer de piel (pues habrá visto antes millones de fotos de cáncer de piel).

Y muy pronto, las empresas serán inteligentes de verdad, en base a la inteligencia artificial y al aprendizaje a partir su propia experiencia.

En el centro de su estrategia estará la acumulación y proceso de datos estructurados y no estructurados, con el fin de extraer todo el conocimiento tácito que se derive. Conocimiento para modificar dinámicamente los precios, para lanzar ofertas precisas, para detectar incipientes tendencias de mercado, para determinar los factores clave de éxito de los productos (más allá de lo que nos diga el cliente), para decidir inversiones financieras, reubicar recursos humanos, o para contrastar la totalidad de su estrategia. Y, en el centro del modelo de negocio, precisaremos un “lago de datos” sobre el cual tomar la práctica totalidad de decisiones corporativas.

El conocimiento tácito será la próxima ventaja competitiva, y la mejor estrategia de negocio la desplegará aquella empresa que tenga la mejor estrategia de inteligencia artificial

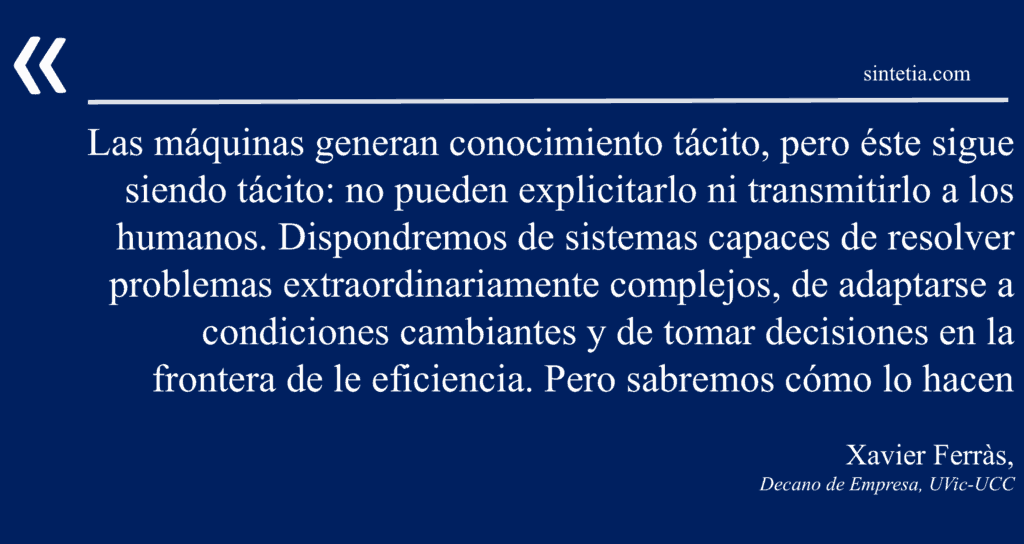

Con todo ello, se nos presenta una inquietud, una duda casi filosófica: ¿cómo codificar el conocimiento tácito ganado por las máquinas? En la medida en que los sistemas aprenden de sí mismos y se auto-programan, el programador humano pierde el control de lo que ocurre y no es capaz de comprender los outputs de la máquina. No sabemos cómo razona una máquina basada en machine learning. Tampoco podemos llegar a comprender, en caso de errores, por qué se producen (ni corregirlos). Las máquinas generan conocimiento tácito, pero éste sigue siendo tácito: no pueden explicitarlo ni transmitirlo a los humanos.

Dispondremos de sistemas capaces de resolver problemas extraordinariamente complejos, de adaptarse a condiciones cambiantes y de tomar decisiones en la frontera de le eficiencia. Dispondremos de empresas con increíbles estrategias de marketing o de gestión de cadena de suministro. Pero no llegaremos a saber cómo lo hacen. La paradoja de Polanyi seguirá siendo válida: en este caso, las máquinas sabrán más de lo que nos explicarán.

2 Comentarios

Genial ese último párrafo, Xavier, colofón de todo tu excelente discurso.

Ya en un artículo mío de hace unos meses indicaba alguna de las incongruencias que se pueden producir. Añado alguna más:

¿Terminará por descubrir la IA nuestro primitivo, frágil y dañino sistema emocional? ¿Caerá en la cuenta de la ingente cantidad de tiempo y recursos que gastamos inutilmente por las interferencias, malentendidos y daño que provocamos? ¿Verán algún sentido en nuestra obsesión por la competitividad, por ser competitivos y por crecer sin límite? ¿Nos llegará a considerar como un peligro para la supervivencia de la vida en el planeta? ¿Harán algo al respecto?

Y en línea con lo que tu dices: ¿nos enteraremos de sus conclusiones y de sus posibles planes?

Blade Runner…

Muy buen artículo. Se me ocurre que podría desarrollarse software basado en machine learning precisamente para entender o traducir a lenguaje/significado humanos los procesos autónomos de aprendizaje de las máquinas. De esa manera, con monitorización y traducción constante, retendríamos el control y el proceso de conocimiento.